모두를 위한 딥러닝 강의 시즌1을 듣고 복습한 내용입니다.

Logistic regression

sigmoid -> 0과 1사이 값으로 바꿔줌

2가지를 구분하는 선을 찾는 것

Multinomial classification, Softmax regression

여러 가지를 구분짓는 선들을 찾는 것

여기까지가 Hypothesis를 만든 것

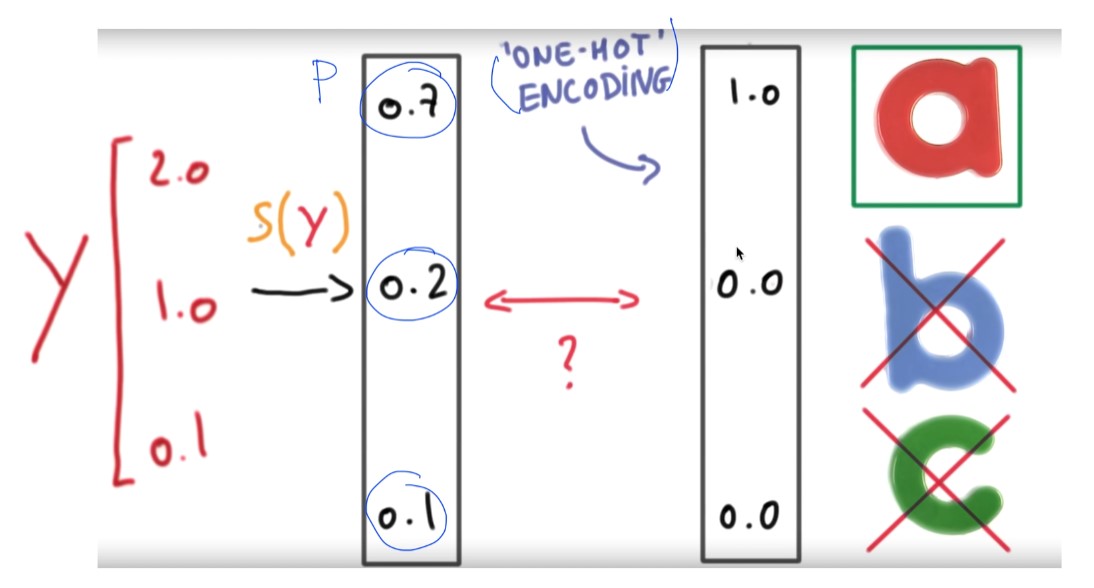

계산을 통해 나온 값(= 확률)으로 a, b, c 중 어느 것인지 구분 가능하다. 확률 높은 것을 남기고 다 0으로 만들어 버리는 것은 one-hot encoding이라고도 한다.

softmax 함수를 사용한다. 특징은 다음과 같다.

- 계산된 확률은 0에서 1 사이

- 모든 확률의 합은 1

- logistic regression의 multinomial-classification 문제에서 사용

sigmoid 함수와의 차이는?

- logistic regression의 binary-classification 문제에서 사용

- 총 합이 1은 아니다.

이후에는 Cost function을 구해볼 것이다. Cost function이 최소화되는 지점을 찾는 것

Cross-entropy cost function이라고 한다. (그게 뭐지)

'딥러닝, 머신러닝 > 모두를 위한 딥러닝 강의 복습' 카테고리의 다른 글

| 딥러닝의 기본 개념(교양) (0) | 2022.01.08 |

|---|---|

| Learning rate, Data preprocessing, Overfitting, Regularization (0) | 2022.01.07 |

| Logistic Classification, Logistic Regression의 cost 함수 (0) | 2022.01.05 |

| TensorFlow로 파일에서 데이터 읽어오기 (0) | 2022.01.04 |

| Multi-variable linear regression (0) | 2022.01.04 |