모두를 위한 딥러닝 강의 시즌1을 듣고 복습한 내용입니다.

학습률, Learning rate (알파)

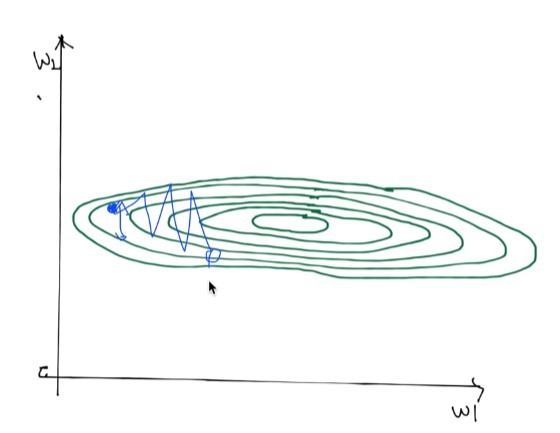

1 step이 너무 크면 발산(수렴하지 않음)해버리는 경우가 생길 수 있다. = overshooting

1 step이 너무 작으면 수렴하는데 너무 오래 걸린다. or 최저점에 도달하지 못하고 중간에 멈출 수도 있다.

=> 적절한 learning rate를 찾아야 함. 처음에 0.01정도로 시작

Data preprocessing이 필요한 이유

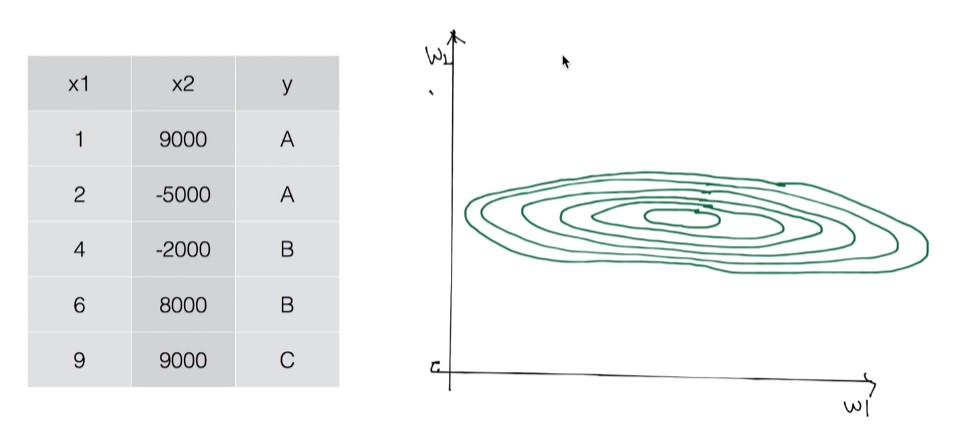

w1, w2 2개의 weight가 있을 때,

다음 그림처럼 x1, x2 값이 매우 큰 차이가 있다면 등고선이 굉장히 납작하게 그려진다.

이 경우 gradient descent를 사용했을 때 cost 값이 튀어버릴 수 있다.

Learning rate가 적절한 것 같은데, 학습이 잘 일어나지 않는 경우에는 data preprocessing, normalization을 생각해보자.

Normalization하는 방법

Overfitting** (중요)

학습 데이터에 대해서는 예측을 잘하는데....

테스트 데이터에 대해서는 예측을 잘 못하는 것

해결책은?

- 더 많은 데이터

- feature의 수 줄이기(중복된 것 있는지 보기)

- Regularization

Regularization (일반화)

cost 함수 뒤에 새로운 항을 추가

학습시킨 모델을 평가하는 방법, 잘 학습시키는 방법

1. 데이터를 Training set과 Test set으로 나누기

training set = like 교과서 공부

test set = like 실전 시험

2. 데이터를 Training set, Validation set, Test set으로 나누기

Learning rate, Regularization strength를 정할 때, training set을 training과 validation set 2개로 나눔

training set으로 학습한 뒤, validation set으로 알파, 람다 값들이 어떤 값이 좋을지 tuning

validation set = like 모의 고사

cf. Online Learning

예) 100만개 데이터가 있을 때(너무 많을 때) 10만개씩 학습 (추가로 학습)

'딥러닝, 머신러닝 > 모두를 위한 딥러닝 강의 복습' 카테고리의 다른 글

| 딥러닝의 기본 개념(교양) (0) | 2022.01.08 |

|---|---|

| Softmax Regression (0) | 2022.01.06 |

| Logistic Classification, Logistic Regression의 cost 함수 (0) | 2022.01.05 |

| TensorFlow로 파일에서 데이터 읽어오기 (0) | 2022.01.04 |

| Multi-variable linear regression (0) | 2022.01.04 |